Crawler Trap et bots IA : comprendre, détecter et corriger les pièges de crawl

Avec l’augmentation du trafic automatisé lié aux bots d’intelligence artificielle, de nombreux sites web découvrent un problème ancien mais désormais critique : le crawler trap.

Un crawler trap peut provoquer une explosion du nombre de requêtes, saturer un serveur web et entraîner des erreurs telles que HTTP 429 – Too Many Requests, voire une indisponibilité complète du site. Ces incidents sont souvent attribués aux bots IA, alors que la cause réelle est presque toujours une faille structurelle du site web.

Qu’est-ce qu’un crawler trap ?

Un crawler trap est une situation où un site génère un nombre infini ou non contrôlé d’URLs distinctes, toutes accessibles et apparemment valides.

Pour un robot :

- Chaque URL unique représente un nouveau contenu potentiel.

- Aucune limite claire de crawl n’existe.

Le robot continue à explorer jusqu’à saturer l’infrastructure, ce qui peut provoquer des erreurs serveur et ralentir ou rendre inaccessible le site.

Pourquoi les bots IA déclenchent les crawler trap plus rapidement

Les bots IA :

- Explorent le contenu de manière plus exhaustive.

- Suivent la pagination plus profondément que les moteurs classiques.

- Collectent massivement le texte et les métadonnées.

- Ont des règles de déduplication plus souples.

Un piège latent peut rester invisible pendant des années et provoquer une panne en quelques minutes seulement.

Types courants de crawler trap

Paramètres d’URL infinis

Chaque page générée par un paramètre dynamique peut créer des milliers d’URLs.

Exemple : /blog?page=1, /blog?page=99999

Recherche interne

Les moteurs de recherche interne génèrent des pages infinies.

Exemple : /search?q=a, /search?q=aa

URLs basées sur les dates

Les URLs calendriers ou événementielles peuvent s’étendre indéfiniment.

Exemple : /events/2099/12/31

Navigation à facettes

Les combinaisons de filtres dans les sites e-commerce créent une explosion d’URLs.

Exemple : /products?color=red&size=42&brand=nike

Identifiants de session

Chaque session peut générer une URL différente pour la même page.

Exemple : /page?session=abc123

Boucles de redirection

Les redirections mal configurées créent un parcours infini pour le robot.

Exemple : HTTP → HTTPS → HTTP

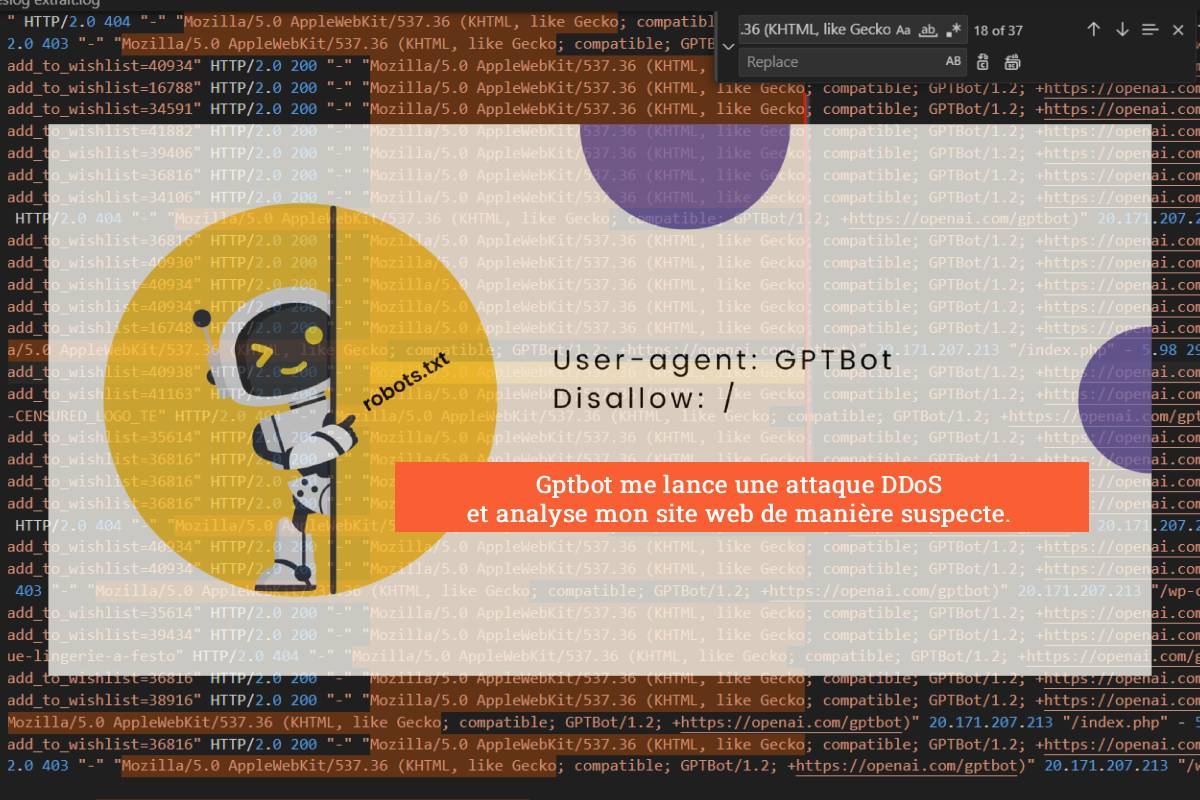

Cas réel : panne causée par un crawler trap (timeline)

Contexte

- Site : Blog technique à fort contenu textuel

- Stack : WordPress + Nginx

- Protection : Rate limiting basique

- Visibilité : Site public sans restriction de crawl

Timeline de l’incident

- 10:12 : Début d’un trafic anormal depuis un user-agent identifié comme bot IA

- 10:15 : Explosion des requêtes sur des URLs de type /search?q=a, /search?q=aa, /search?q=aaa

- 10:18 : Charge CPU multipliée par quatre, saturation de PHP-FPM

- 10:20 : Déclenchement du rate limiting, erreurs 429

- 10:22 : Le site devient partiellement inaccessible pour les utilisateurs

- 10:25 : Analyse rapide des logs révèle un crawler trap sur la recherche interne

- 10:30 : Blocage temporaire via robots.txt

- 10:33 : Chute immédiate du trafic automatisé

- 10:40 : Retour à la normale pour les utilisateurs

Analyse post-incident

- Le bot n’était pas malveillant

- La recherche interne générait des URLs infinies

- Il n’y avait aucune limite de pagination

- Les pages vides retournaient un code HTTP 200 OK

→ Crawler trap confirmé

Mesures immédiates recommandées

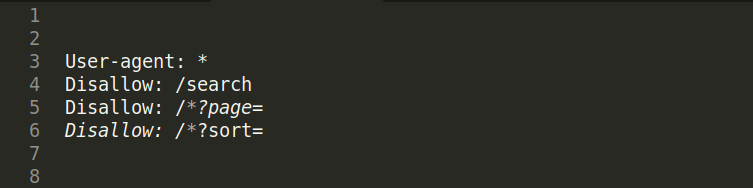

Blocage via robots.txt

- Bloquer les zones à risque du site :

Rate limiting comportemental

- Limiter les requêtes par IP

- Limiter les requêtes par minute

- Limiter l’accès aux endpoints dynamiques sensibles

Corrections durables pour WordPress et SEO

Désindexer la recherche interne

- Paramètres → Lecture → Décourager les moteurs de recherche

- Ou bloquer via robots.txt

Limiter la pagination

- Crawler Trap et bots IA : comprendre, détecter et corriger les pièges de crawlDéfinir une page maximale (exemple : page 100)

- Au-delà, retourner un code HTTP 404 ou 410

URLs canoniques

Utiliser Yoast SEO ou RankMath pour définir la page principale d’un contenu

Corriger les codes HTTP

- Pages de recherche vides → 404

- Filtres sans résultat → 410

Sécuriser les redirections

Vérifier HTTPS, www et slash final pour éviter les boucles

Ce que robots.txt ne protège pas

- Les bots malveillants

- Les user-agents falsifiés

- Les attaques DDoS ou saturations massives

Pour ces cas, utiliser un WAF ou un service comme Cloudflare est recommandé

Bonnes pratiques WordPress face aux bots IA

- Bloquer /wp-json/ si inutilisé

- Désactiver la recherche publique si elle n’est pas nécessaire

- Surveiller régulièrement les logs serveur

- Tester la résistance au crawl automatisé

Conclusion

Les crawler trap sont des failles structurelles révélées par les bots IA.

Bloquer un bot peut résoudre une urgence, mais corriger le piège reste indispensable pour assurer la stabilité, la performance et la qualité SEO du site.

Un site moderne doit être conçu pour résister à une exploration profonde et agressive tout en protégeant les ressources serveur.