Améliorez votre SEO grâce au fichier robots.txt

Le fichier robots.txt est un outil puissant mais souvent sous-utilisé dans le monde du référencement naturel (SEO). En définissant les règles pour les moteurs de recherche sur les pages à explorer ou ignorer, ce petit fichier peut avoir un impact significatif sur la manière dont votre site est indexé. Cet article explore en détail ce qu’est le fichier robots.txt, son importance pour le SEO, et comment l’optimiser pour améliorer les performances de votre site.

Qu’est-ce que le fichier robots.txt ?

Le fichier robots.txt est un fichier texte placé à la racine de votre site web. Il sert de guide pour les robots d’exploration (comme Googlebot), en spécifiant quelles parties de votre site ils peuvent ou ne peuvent pas explorer. Par ailleurs, il permet :

- Contrôle de l’exploration : Il vous permet de bloquer l’accès à des pages ou sections spécifiques de votre site, économisant ainsi le crawl budget.

- Réduction du contenu dupliqué : Empêchez l’indexation de pages similaires ou répétitives pour éviter les pénalités de Google.

- Protection des données sensibles : Bloquez l’accès à des fichiers non destinés au public, comme les pages d’administration.

Où le trouver ?

Le fichier robots.txt est accessible à l’adresse suivante :

https://www.votresite.com/robots.txt.

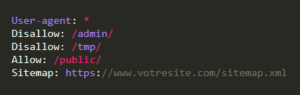

Structure et syntaxe du fichier robots.txt

Un fichier robots.txt suit une structure simple, composée de directives spécifiques. Voici les principales :

Les directives principales

- User-agent : Spécifie le robot auquel la règle s’applique. Par exemple, User-agent: * s’applique à tous les robots.

- Disallow : Indique les pages ou répertoires que les robots ne doivent pas explorer.

- Allow : Permet d’accéder à des sous-dossiers ou fichiers spécifiques même si un répertoire parent est bloqué.

- Sitemap : Indique l’emplacement du fichier sitemap.xml pour faciliter l’exploration.

Exemple de fichier robots.txt

Voici un exemple typique :

Dans cet exemple :

- Tous les robots sont ciblés.

- L’accès au répertoire /admin/ et /tmp/ est bloqué.

- Le répertoire /public/ reste accessible.

- Le fichier sitemap est indiqué pour guider les robots.

L’impact du fichier robots.txt sur le SEO

Amélioration du crawl budget

Le crawl budget, ou la fréquence à laquelle Google explore votre site, est limité. En utilisant robots.txt pour bloquer les pages non essentielles, vous concentrez l’exploration sur vos pages prioritaires.

Gestion du contenu dupliqué

Certains sites contiennent des versions multiples d’une même page (exemple : filtres ou pages de résultats). En empêchant l’exploration de ces pages via robots.txt, vous évitez que Google les considère comme du contenu dupliqué.

Optimisation des performances

Bloquer les ressources inutiles (comme les fichiers CSS ou JS non essentiels pour l’indexation) améliore la rapidité de l’exploration et réduit la charge sur votre serveur.

Contrôle de la confidentialité

Empêchez l’indexation de fichiers sensibles (comme des bases de données ou des fichiers d’administration) pour éviter qu’ils n’apparaissent dans les résultats de recherche.

Conseils pour optimiser le fichier robots.txt

Identifiez les pages à exclure

Listez les pages ou sections qui n’ont pas besoin d’être explorées par les moteurs de recherche, comme :

- Pages de connexion ou d’administration.

- Pages de confirmation ou de panier sur les e-commerces.

- Pages générées dynamiquement, comme les filtres ou résultats de recherche interne.

Ne bloquez pas les ressources importantes

Assurez-vous que les ressources nécessaires au bon affichage et à l’analyse de votre site (CSS, JS, images) ne sont pas bloquées. Si ces fichiers sont bloqués, Google pourrait mal interpréter votre contenu.

Testez votre fichier robots.txt

Utilisez l’outil robots.txt Tester dans Google Search Console pour vérifier que vos directives fonctionnent comme prévu. Cela vous permettra d’identifier et de corriger les erreurs.

Déclarez votre sitemap

Ajouter l’emplacement de votre fichier sitemap dans robots.txt aide les moteurs de recherche à explorer votre site de manière plus efficace.

Utilisez des règles spécifiques

Si votre site a besoin de directives différentes pour certains robots, créez des règles spécifiques.

Faites attention à ces erreurs !

Bloquer par erreur des pages importantes

Une erreur fréquente est de bloquer accidentellement des pages cruciales pour le SEO. Par exemple : Disallow: /

Cela bloque l’ensemble de votre site.

Confusion avec la balise noindex

Le fichier robots.txt empêche l’exploration, mais il ne garantit pas que la page sera exclue de l’indexation. Pour éviter l’indexation, utilisez également la balise noindex dans le code HTML.

Ignorer les tests réguliers

Les modifications dans robots.txt peuvent avoir des impacts négatifs sur votre SEO. Testez régulièrement vos règles pour éviter des pertes de trafic.

Mauvaise gestion des sous-domaines

Chaque sous-domaine doit avoir son propre fichier robots.txt. Ne présumez pas qu’un fichier robots.txt principal s’applique à tous vos sous-domaines.

Les indispensables pour gérer votre fichier robots.txt

- Google Search Console : Pour tester et surveiller vos directives robots.txt.

- Screaming Frog : Analysez les URLs bloquées pour identifier d’éventuelles erreurs.

- Ahrefs ou SEMrush : Suivez les pages explorées par les robots et optimisez vos directives en conséquence.

- Robots.txt Generator : Créez un fichier robots.txt conforme aux bonnes pratiques.

Le mot de la fin

Bien utilisé, le fichier robots.txt permet de maximiser votre crawl budget, de gérer le contenu dupliqué et de protéger les données sensibles de votre site. Investir du temps pour l’optimiser est donc recommandé pour rester compétitif dans un environnement numérique en constante évolution. Avec l’intégration croissante de l’intelligence artificielle et de nouvelles technologies d’exploration, des fonctionnalités supplémentaires pourraient être introduites pour offrir un contrôle encore plus précis.